答案是:并不是。

一

前阵子创投圈有个还蛮有名的投资人也是当年快车的创始人陈伟星,痛斥算法推荐。套路还是那个套路:算法推荐导致(leads to)信息茧房,而信息茧房,害死人。

陈氏是字节的早期投资人,当年的1000万美元现在不知道变成了多少。看上去颇有点恨其不争的杀回马枪的意思。不过,第二天,他就宣布要搞一个“5210计划”:用完全透明化的方式创立新的社交媒体平台,云云。

没几天,一位蛮火的书籍带货人吴主任,就写了一篇文章,对陈伟星表示了强烈的不以为然。

吴主任倒是在抖音上刷到过很多回他在卖书,主要书目都是人文社科,有带货上万册的记录。

查了查,吴主任也是互联网老兵了,门户时代出来的人,怪不得文章里会提到google reader和抓虾这种古老的订阅制产品。

吴主任的这篇文章,主要分为两个观点:其一,在茧房问题上,订阅制可比算法推荐厉害得多。其二,即便这些互联网技术都没有,人要低劣没品起来不照样低劣没品。

二

订阅制是一种人的主动行为。人之所以会有这个主动行为,无非就是:这个信息源探讨的事我感兴趣,或者,这个信息源的立场和我一致(所谓三观契合)

订阅同时也是一个瞬时发生的开关行为,在一秒钟内,就可以完成订阅或者退订。也就是说,建立或断开与这个信息源的连接,非常容易做到。

请注意,订阅不仅仅是订阅各种号,也包括关注某人,与某人建立“朋友”的连接。

但算法推荐不是。一套符合某人口味(这个口味包括兴趣和立场)的算法,需要某人自己花上一定的时间去调教。算法推荐远没有你想象得那么“准”。

而且算法推荐聚焦于你的兴趣,而不是你的立场。一件让你感兴趣的事,完全有可能有不同立场的阐述。

如果你有坚定不移甚至偏执的立场,算法推荐可能是有效的。因为你会有一些足以标记出来的行为:符合立场的信息花了很长时间,严重冲突对立的,会很快关闭。或者,你发表了鲜明立场的评论留言。

但不得不承认,在大多数事件上,大多数人没有那么鲜明的立场。

缺少足够的证据来证明,基于兴趣的推荐算法,会形成极化观点。但人类历史早已有过案例,一个局促封闭的社交网络,倒是会让人极化。比如,原教旨主义小团体。

信息茧房其实是一种假说(hypothesis)而不是被证实的理论,因为当今世界要形成一个完全封闭的信息网络其实很难。退一步,即便信息茧房在普通人身上真的存在,那么,社交网络远比算法推荐来得更有可能。

但算法推荐不是没有问题。

三

不实信息对算法推荐的破坏性,非常有可能,超过了对社交网络的污染。

就单一文本而言,算法想要判断出这个文本是谣言还是事实,非常困难。它需要结合大量的其它文本信息。而有时候算法真得没你想得那么强大。

人工智能强悍如ChatGPT这类LLM,也曾犯下“华盛顿是美国第一任总统”但同时又给出“美国第一任总统不是华盛顿”的错误(此文有点标题党,可以忽略标题细读正文)

这种a是b但b却不是a的错误,在人类面前,会显得非常智障。

到目前为止,社交网络的各个节点,大多数都是人类。在不少不实信息面前,人类具有识别的能力。每一个节点都会在一定程度上担当一个过滤器的角色。而算法推荐,缺少这个机制。

所以,对于一个算法平台的内容生态健康度,最大的威胁不是算法,而是内容本身。

四

不实信息有很多种,首当其冲的就是谣言。

被证伪过的谣言,可以设定特定的标记,去过滤那些谣言的复制版本以阻断传播,多多少少还是有些法子。但还有一些不实信息,处理起来就困难许多。

比如在短视频平台上,会发现不当摆拍和伪公益这类不实信息。

摆拍很容易让观看者以为确有其事,当成真实事件处理。比如一度非常火的被大量翻拍过的一个桥段:“外卖骑手”带着孩子送外卖,点餐人打开房门拿外卖的一刻,本想对迟到的骑手发火,但看到骑手身后楚楚可怜的孩子,转而表示感谢。这则看上去像是个正能量的暖新闻,事后被证实都是伪装“新闻现场”。

伪公益也是摆拍的一种,但由于聚焦于善心,更容易打动观看者的恻隐之心。比如一个伪公益视频是这样的:一位善心人到农村给老人送钱,每人一送就是上千元。靠修自行车讨生活的父亲得知后发飙,提着棍子来阻止儿子。善心人奔逃之余,还是硬把善款塞到了农村老人手中。

而这些信息,算法是很难去识别到底是真是伪的,即便出演者演技夸张拙劣到一眼假的地步。算法推荐有一个基本法则,就是观看效果越好就越值得推荐。于是,在最终被证伪之前,传播量其实已经不小了。

随着AI技术的日新月异,现在数字人也不是什么实验室中的产品。不用怀疑,你绝对有可能收看过数字人的视频作品。

数字人通过采集真人的视频和音频素材,生成一段新视频,然后可以将任意事先最好的文案,生成到这个视频里。看上去就像这个真人真地就在那里侃侃而谈一样。

这在一些特定场景下,确实容易产生对观看者的误导。

四

不实信息如果泛滥成灾,对算法平台是一个巨大的威胁。平台在强化自身能力的同时——比如抖音在去年12月上线了一个能达到准确率85%的识别摆拍模型——更需要生产者一起参与进来。毕竟,85%这个数字看上去很大,但考虑到内容的海量,依然会有不少漏网之鱼。

抖音的做法是在2023年,推出了主动打标和一系列平台新规。所谓主动打标,即不仅仅是平台对内容做出标识,内容生产者也需要对自己的内容做出适当标识。

首先是对谣言的治理,平台自主打标,以阻挡传播。信息一旦被证伪后,打标这个动作比较容易实施,这在年头2月,就已经开始。

3月份,更新了《剧情演绎类作品创作规范》,这是针对摆拍类作品,要求创作者自行打标,比如“虚构演绎,仅供娱乐”“取材网络,谨慎辨别”等。不涉及破坏公序良俗的摆拍不是不可以,但不能误导观看者以为这是新闻现场。

5月份,更新了《公益内容治理的最新规范》,公益账号需要认证,且不能参与直播打赏、电商带货这类商业行为。

同月,发布了《关于人工智能生成内容的平台规范暨行业倡议》,主要针对aigc的部分,aigc(比如数字人搞直播)需要创作者自行标识识,账号需要认证。

9月,推出了《内容标识使用规范》,明确了打标这个动作的行为细节。

过去的这一年,有数百万条视频,创作者进行了自主标识。

五

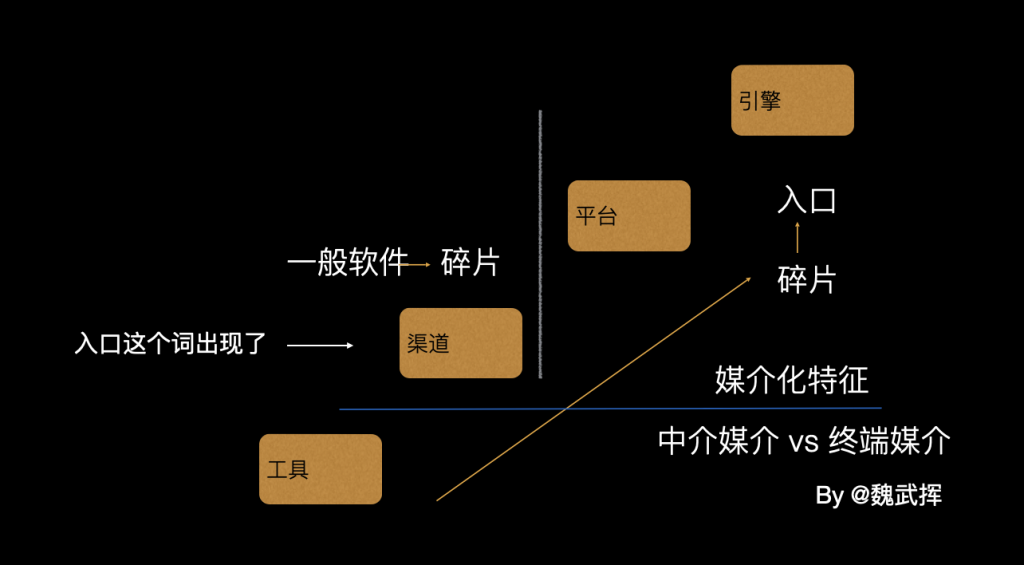

一直以来,我有一个看法,互联网内容生态的很多问题,被有意无意地误导成传播渠道问题了。渠道本身确实是有可能把既有的问题放大,但要说问题之本,绝不在渠道之上。

如果市场上到处是假货泛滥,这板子要打,也不能主要打到超市身上不是。

算法推荐,它的核心要害是内容本身,而不是内容分发机制。

茧房不茧房的,都是假说(hypothesis)层面的东西,完全可以放一放。先正视不实信息这一确凿无疑的危害,行不行?我总觉得今天有很多人会觉得信息茧房是一个很有逼格的词,一聊就有高大上的深刻洞见感,而不实信息似乎极其普通而不愿意多碰。

国内基于算法推荐的信息平台很多,抖音只是其中一个。但抖音这个会同内容生产端来共同标识内容,虽然不能做到完全治理不实信息,但至少也是向前走了一步,这一步,是值得其他平台去借鉴的。

—— 首发 扯氮集 ——